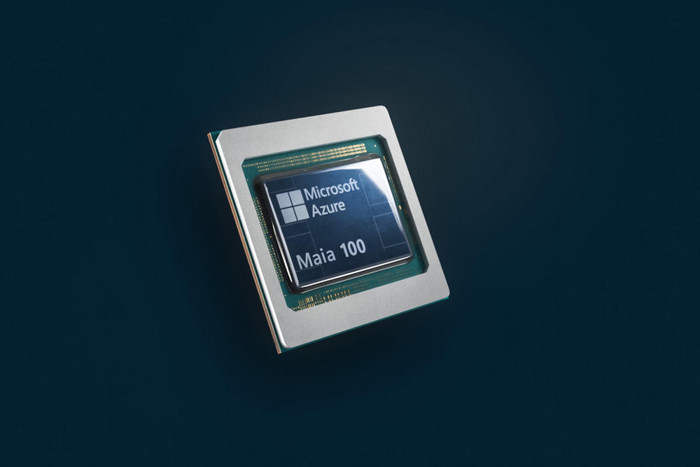

Tại hội nghị Ignite diễn ra vào ngày 15/11, Microsoft đã chính thức ra mắt hai mẫu chip mới nhất của công ty, bao gồm Maia 100 và Cobalt 100 Arm.

Cụ thể, chip trí tuệ nhân tạo Maia 100 được nhắc đến với khả năng cạnh tranh với phiên bản xử lý đồ hoạ AI nổi tiếng của Nvidia. Loại thứ hai, chip Cobalt 100 Arm, nhằm vào các tác vụ tính toán thông thường và có thể cạnh tranh với bộ xử lý Intel.

Microsoft đang tiếp tục thử nghiệm Maia 100 trong việc đáp ứng nhu cầu của chatbot AI trong công cụ tìm kiếm Bing (hiện được gọi là Copilot thay vì Bing Chat), trợ lý mã hóa GitHub Copilot và GPT-3.5-Turbo - một mô hình ngôn ngữ lớn từ OpenAI do Microsoft hậu thuẫn. OpenAI đã cung cấp cho các mô hình ngôn ngữ của mình một lượng lớn thông tin từ internet và chúng có thể tạo email, tóm tắt tài liệu và trả lời các câu hỏi bằng một vài lời hướng dẫn của con người.

Bên cạnh Maia 100, phiên bản Cobalt 100 Arm đang được Microsoft thử nghiệm trên ứng dụng Teams và dịch vụ Cơ sở dữ liệu Azure SQL. Theo chia sẻ của công ty, chúng có hoạt động tốt hơn 40% so với các chip cũng dựa trên thiết kế Arm hiện có của Azure, đến từ công ty khởi nghiệp Ampere.

Rani Borkar, phó chủ tịch công ty, nói với CNBC trong một cuộc phỏng vấn rằng các phiên bản máy ảo chạy trên chip Cobalt sẽ có sẵn trên thị trường thông qua đám mây Azure của Microsoft vào năm 2024. Bà không cung cấp mốc thời gian phát hành Maia 100.

Ngoài việc thiết kế chip Maia, Microsoft còn phát minh ra phần cứng làm mát bằng chất lỏng tùy chỉnh có tên Sidekicks, đặt vừa trong các giá đỡ bên cạnh máy chủ Maia.

Bà Rani Borkar đưa ra lưu ý thêm rằng bà không có chi tiết so sánh hiệu suất của Maia và các lựa chọn thay thế như H100 của Nvidia. Vào đầu tuần này, Nvidia cho biết H200 của họ sẽ bắt đầu xuất xưởng vào quý 2/2024.

Đến nay, các công ty công nghệ lớn đã nỗ lực để mang đến cho khách hàng các lựa chọn đa dạng về cơ sở hạ tầng đám mây được sử dụng để chạy các ứng dụng. Alibaba, Amazon và Google đã đã làm điều này trong nhiều năm. Theo một ước tính, Microsoft, với khoảng 144 tỷ USD tiền mặt vào cuối tháng 10, chiếm 21,5% thị phần đám mây vào năm 2022, chỉ sau Amazon.

Google đã công bố bộ xử lý tensor đầu tiên dành cho AI vào năm 2016. Amazon Web Service đã tiết lộ mẫu chip dựa trên Graviton Arm và bộ xử lý Inferentia AI vào năm 2018, đồng thời công bố Trainium, dành cho các mô hình đào tạo, vào năm 2020.

Các chip AI đặc biệt từ các nhà cung cấp đám mây có thể giúp đáp ứng nhu cầu khi thiếu GPU. Nhưng khác với Nvidia và AMD, Microsoft và các công ty cùng ngành trong lĩnh vực điện toán đám mây không có kế hoạch cho phép các công ty ngoài mua máy chủ chứa chip của họ.